Innovation

La révolution des agents : récapitulatif 2025 et perspectives pour 2026

Hier, je me suis retrouvé à replonger dans d’anciens projets agentiques datant de l’âge préhistorique des LLMs (il y a deux ans), et j’ai vraiment réalisé à quel point l’écosystème avait évolué. Je suis passé de concevoir des agents pour commander des pizzas au drive avec GPT‑3.5 à déployer des agents de niveau production dans des ERP d’entreprise. De mes conférences à WeAreDeveloper à Berlin à Confoo ici à Montréal et NDC à Londres, j’ai été complètement plongé dans le zeitgeist des agents.

Tout le monde annonçait 2025 comme « l’année des agents », et, wow, elle a tenu ses promesses. Revoir tout ce qui a changé en seulement douze mois, c’est comme voir une ville se construire à toute vitesse.. Les infrastructures ont émergé, les standards se sont solidifiés, et ce qui était auparavant des hacks expérimentaux est devenu des systèmes de production presque du jour au lendemain. Alors, après tout ce temps passé sur le terrain, voici mon petit récapitulatif de ce qui a rendu 2025 si crucial et ce à quoi 2026 pourrait ressembler.

Des fondations posées plus vite que prévu

Imaginez ceci : le Model Context Protocol (MCP) n’a même pas un an. Anthropic l’a rendu open-source en novembre 2024, et dès février 2025, il était déjà devenu le protocole de référence pour l’infrastructure des agents. Une adoption à une vitesse qui ferait pleurer de joie n’importe quel fondateur tech. Ce mois-ci à peine, MCP a fêté son premier anniversaire avec le lancement de MCP 2.0, apportant l’exécution de code et le multi-tool calling, ce qui change fondamentalement la manière dont les agents orchestrent des workflows complexes.

Et surprise : les grandes entreprises tech n’ont pas juste observé ou tenté de créer leur propre protocole, elles ont misé à fond sur MCP. Google a récemment annoncé des endpoints MCP entièrement gérés pour toute sa stack cloud, de Maps à BigQuery, rendant leurs services « prêts pour les agents dès la conception ». Plutôt que d’écrire des connecteurs personnalisés fragiles qui cassent à chaque changement d’API, un agent IA peut maintenant se brancher directement aux APIs de Google via un endpoint MCP standardisé. Voilà le genre d’interopérabilité que l’on veut pour les agents.

Et puis il y a eu le « vibe coding ». Le terme n’a même pas un an. Andrej Karpathy l’a lancé en février sur X pour décrire le moment où l’on abandonne la micro-gestion de l’agent codeur et où l’on se laisse « viber » avec lui. Aujourd’hui, c’est ancré dans les décisions d’affaires, les workflows de développement et les sessions de prototypage. Oui, ça a déclenché des débats sur l’accumulation de dette technique, mais le génie est sorti de la bouteille. On code autrement maintenant, et il n’y a pas de retour en arrière.

L’explosion créative

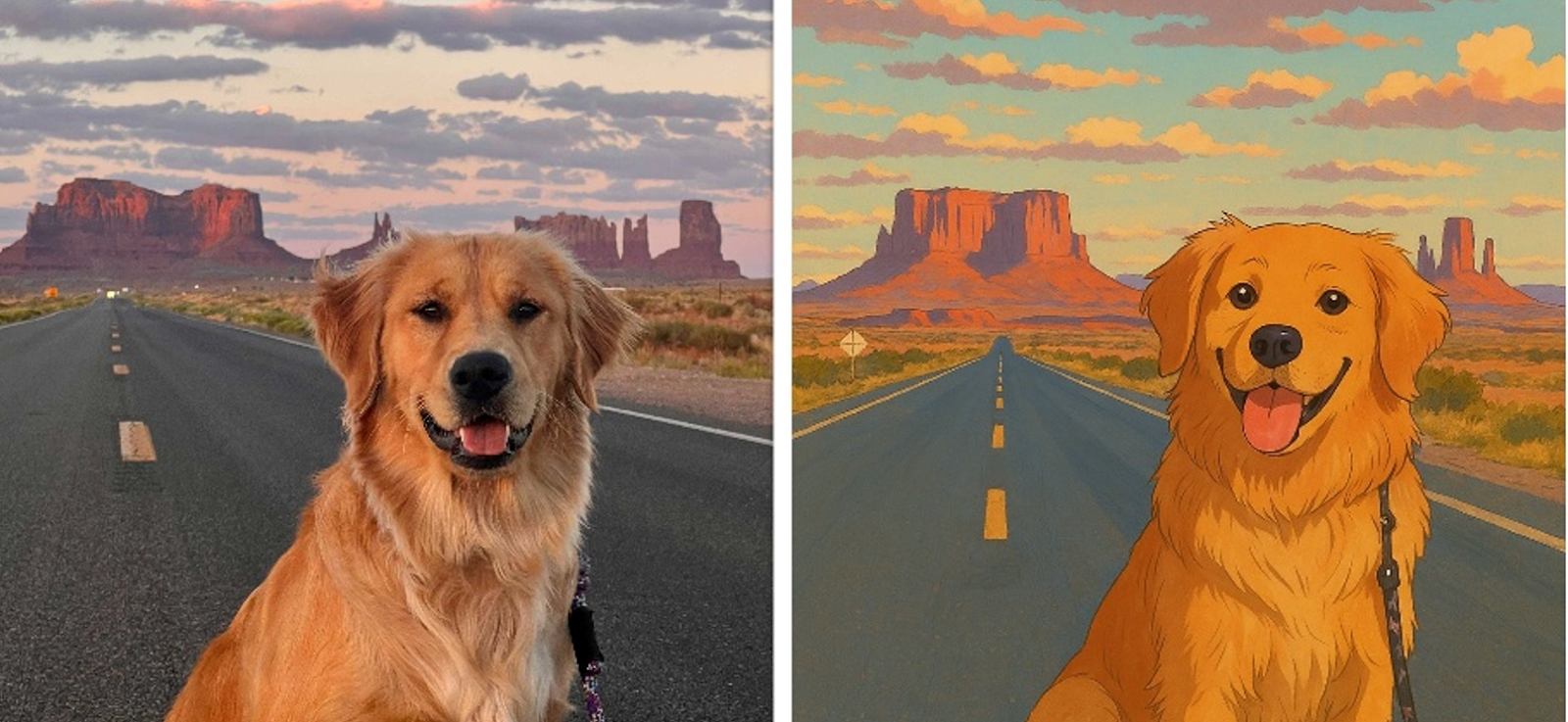

Même si ce n’est pas directement lié aux agents, ça mérite d’être mentionné. Peu après l’entrée du vibe coding dans notre lexique, on a assisté à la « ghiblification » d’Internet. Le modèle de génération d’images d’OpenAI a enfin maîtrisé le texte dans l’image et le transfert de style, rendant les tableaux Pinterest de tous les marketeurs réalisables en un instant. Mais ça a été rapidement éclipsé par la sortie estivale de Nano Banana et Nano Banana Pro, qui permettent un montage photo ultra précis façon Photoshop, sans perte de fidélité par rapport à l’image source. Pour quelqu’un qui manie à peine GIMP, voir l’IA gérer des retouches complexes, c’est de la pure sorcellerie technologique. J’ai passé DEUX JOURS à ghiblifier des images de mon chien.

Le domaine de la génération vidéo a explosé aussi. On est passé de Veo3 à Sora, qui ajoute sons et effets synchronisés, puis à Cameos, qui intègre ton visage dans des vidéos de manière impressionnante… et un peu inquiétante. Netflix a utilisé du contenu généré par IA dans ses productions cette année, Coca-Cola a lancé sa deuxième campagne de Noël générée par IA, et Disney a signé un accord avec OpenAI pour inclure ses personnages dans Sora. Et juste au moment où l’on pensait que le rythme allait ralentir, Meta sort son SAM 3D Model, permettant de passer d’images à la 3D et ouvrant de nouvelles dimensions créatives.

La maturité du langage de développement agentique

L’espace de développement des agents a mûri si vite que des concepts qui étaient du jargon en début 2025 sont maintenant partie intégrante des conversations techniques. Le prompt engineering et la retrieval augmented generation (RAG) sont passés des publications scientifiques aux attentes de base. Mais plus intéressant encore, on a vu émerger le context engineering, terme qui englobe la majorité de la discipline de conception des systèmes agentiques tout en apportant une structure nécessaire au vocabulaire.

Le context engineering nous a donné un langage pour discuter de problèmes que l’on vivait tous sans pouvoir les formuler. Des termes comme context compaction, context rot et context poisoning permettent de mieux structurer les idées et de déboguer les comportements des agents. C’est un peu comme si la programmation avait reçu ses design patterns, et soudain, tout le monde pouvait parler des mêmes problèmes avec le même langage.

Anthropic a été à l’avant-garde de cette vague d’innovation avec Claude Code, s’attaquant au problème complexe des agents capables de raisonner sur une base de code sur de longues périodes. Ils ont démontré des concepts comme la context compaction autonome, où le contexte est intelligemment résumé au-delà d’un certain seuil, permettant des conversations multi-tours très longues sans perdre la cohérence.

Puis, à l’automne, Anthropic a introduit un autre concept crucial : l’agent harnessing. Cela désigne l’infrastructure logicielle, les boucles de contrôle et les environnements structurés autour d’un modèle IA pour qu’il se comporte comme un agent autonome fiable. Le harness combat essentiellement l’effet « memento » que les agents expérimentent lorsqu’ils démarrent un nouveau fil de conversation, les aidant à se recentrer sur l’objectif global avec un alignement contextuel adéquat. Comme le dit l’équipe d’ingénierie, le harness transforme un modèle sans état en agent orienté objectif capable de produire des résultats dans le temps.

Standards ouverts pour l’espace agentique

C’est ici que ça devient vraiment excitant pour 2026 et au-delà. En décembre 2025, Anthropic a donné MCP à la Agentic AI Foundation (AAIF) nouvellement formée sous l’égide de la Linux Foundation. L’AAIF a été lancée avec des contributions d’Anthropic, OpenAI et Block, combinant des projets comme MCP, la spécification AGENTS.md d’OpenAI pour les agents codeurs et le framework « goose » local-first de Block. Ce modèle de gouvernance ouverte signale que le développement agentique est passé des hacks propriétaires à un écosystème collaboratif soutenu par des institutions sérieuses.

Les poids lourds sont tous impliqués : AWS, Google, Microsoft, Anthropic et OpenAI sont membres de l’AAIF. Comme l’a déclaré la Linux Foundation : « L’IA agentique représente une nouvelle ère de prise de décision autonome qui transformera les industries », soulignant que la gouvernance ouverte est essentielle pour que cette technologie évolue de façon transparente et stable.

Selon la Linux Foundation, MCP compte déjà plus de 10 000 endpoints de serveur publiés couvrant tout, des outils développeurs aux bases de données du Fortune 500. Il a été adopté sur des plateformes allant de Microsoft Copilot à ChatGPT d’OpenAI et Gemini de Google. En 2026, on vise une véritable interopérabilité : les agents construits sur différentes plateformes ou clouds parleront un langage commun via des « tool API ». Fini les jardins clos et le verrouillage propriétaire. Juste des standards.

Des systèmes multi-agents plus complexes

À mesure que les agents deviennent plus capables, on voit émerger la collaboration multi-agent et une mémoire à long terme plus riche. Un agent unique qui gère des tâches simples est utile, mais les problèmes complexes nécessitent des agents spécialisés travaillant en concert. Selon Salesforce, les entreprises de pointe « passent d’une IA monolithique à un modèle de workforce orchestrée », où un agent principal orchestre des sous-tâches déléguées à des agents experts, un peu comme un gestionnaire humain.

En 2026, ces systèmes multi-agents atteindront le déploiement grand public. Un chatbot seul qui ne répond qu’aux questions sera considéré comme une « île morte de valeur limitée », tandis qu’un réseau d’agents collaborant à travers départements et organisations pourra gérer des workflows de bout en bout.

Cela ouvre des portes fascinantes pour la collaboration inter-entreprises. Traditionnellement, les organisations configuraient des systèmes multi-agents hiérarchiquement, mais maintenant, des agents de haut niveau peuvent représenter des organisations entières, négocier et collaborer avec d’autres agents organisationnels. C’est là qu’un protocole comme x402 de Coinbase devient pertinent, permettant à un agent de déléguer du travail à un autre agent autonome via des microtransactions, sans intervention humaine.

Moins de framework, plus d’observabilité

Une étude récente d’IBM, Measuring Agents in Production, montre que 85 % des cas d’étude détaillés abandonnent les frameworks tiers, préférant construire des applications agentiques personnalisées. Cela correspond aussi à mon expérience personnelle. À mesure que les boucles agentiques évoluent et que le context engineering prend de l’importance, il devient évident qu’orchestrer soi-même ses étapes est souvent plus efficace que de se battre contre les opinions d’un framework.

On réalise aussi que dans les systèmes agentiques complexes, l’observabilité n’est plus optionnelle, elle est fondamentale. On verra un accent plus important sur l’évaluation des agents et les standards d’observabilité via OpenTelemetry, conventions sémantiques et distributed tracing. Le rapport d’Anthropic How enterprises are building AI agents in 2026 décrit cette complexité : « Le passage de l’automatisation de tâches à l’orchestration de processus représente un cas d’usage et une proposition de valeur fondamentalement différents. Les organisations maîtrisant le déploiement multi-étapes et cross-fonctionnel peuvent débloquer vitesse, cohérence et échelle qu’une simple automatisation ne permet pas. »

Actuellement, selon IBM, 74 % des agents en production reposent principalement sur l’évaluation humaine, plus de la moitié utilisant aussi le « LLM as judge », toujours avec vérification humaine. Une minorité construit des benchmarks formels. Beaucoup se basent sur des tests A/B, feedback expert ou tests personnalisés. Il y a un énorme potentiel d’amélioration des méthodologies d’évaluation des agents, et 2026 pourrait bien être l’année où on résout ce problème.

Sécurité, gouvernance et mentalité « agent comme employé »

La direction sécurité de Microsoft affirme que « chaque agent devrait bénéficier des mêmes protections que les humains » en entreprise. Cela signifie que chaque agent IA déployé aura une identité numérique et des limites d’accès, comme un employé humain. En 2026, les entreprises traiteront les agents comme des entités de premier plan dans les systèmes de gestion d’identité, avec des crédentials uniques, journaux d’audit et limites de permission. Un agent pourra visualiser certaines données sans les modifier ou exécuter des transactions jusqu’à un certain plafond.

Les organisations mettent en place monitoring et garde-fous : chaque action d’un agent est traçable et justifiée. Un comportement anormal déclenchera alertes ou arrêt automatique. Le sandboxing et les politiques d’exécution se généraliseront, où les agents ne peuvent effectuer que des opérations autorisées et les données sensibles qu’ils produisent sont automatiquement classifiées ou redécoupées.

Une tendance concrète : le suivi de l’adhérence aux instructions devient un indicateur clé. Plutôt que de vérifier seulement si un agent produit la sortie correcte, les entreprises mesureront sa capacité à suivre directives et contraintes. Les experts prévoient l’adoption d’un score probabiliste d’adhérence, une norme de gouvernance IA. Cela reflète le passage de l’expérimentation à la production : fiabilité et prévisibilité sont essentielles pour faire confiance aux décisions autonomes.

L’essor des petits modèles de langage spécialisés

Les petits modèles de langage (SLM) affinés deviendront plus fréquents dans les déploiements d’agents d’entreprise en 2026. Avec les cas d’usage passant en production et des contraintes de calcul ou conformité, le harnessing efficace et le context engineering donneront plus d’importance à la vitesse d’inférence, l’optimisation des tokens et la réduction des coûts.

Avec des usages en production et des systèmes d’observabilité en place, des golden datasets pourront être collectés pour du fine-tuning, améliorant précision et coût. Les grands modèles géreront souvent le contrôle maître d’un workflow agentique, tandis que les SLM dédiés fourniront l’efficacité et la précision nécessaires pour leurs tâches spécifiques. Toutes les entreprises comprendront l’importance de leurs données pour créer de la valeur IA, et les SLM fine-tunés seront essentiels pour l’exploiter pleinement.

De l’expérimentation à l’opérationnel

Si 2025 était l’année de l’expérimentation avec des assistants IA, 2026 sera celle de l’opérationnalisation des agents IA au quotidien. Bien faits, ces agents peuvent libérer les employés des tâches pénibles, augmenter la productivité et ouvrir des façons créatives de travailler auparavant impossibles. Une équipe finance pourrait clôturer les livres en secondes grâce à une armée d’IA, ou le service client offrir une résolution instantanée 24/7 via un réseau d’agents intelligents comprenant le contexte et agissant en conséquence.

L’infrastructure est là. Les standards s’adoptent. Les cadres de sécurité mûrissent. Les outils s’améliorent chaque mois. On est passés de « peut-on construire des agents ? » à « comment les déployer à grande échelle de manière responsable ? ». Une question complètement différente, mais celle qu’il faut poser.

Alors, en 2026, gardez un œil sur la collaboration inter-entreprises, la maturation des standards d’observabilité et la montée des SLM affinés. Si votre organisation veut dépasser l’expérimentation pour passer au déploiement agentique de production, nous pouvons vous aider. Que vous exploriez comment les agents pourraient s’intégrer à vos workflows ou soyez prêts à les intégrer à vos systèmes, nous pouvons vous guider, éviter les pièges et construire quelque chose qui fonctionne réellement.

Intéressé à discuter de ce que l’IA agentique peut débloquer pour votre organisation ? Contactez-nous et on en discute ensemble.

Cet article vous a donné des idées ? Nous serions ravis de travailler avec vous ! Contactez-nous et découvrons ce que nous pouvons faire ensemble.

-min.jpg)